生成式AI的应用越来越多地在各种终端侧落地,AI端侧化的趋势得到从芯片厂商、OEM厂商、ODM厂商到上层应用厂商的认同。

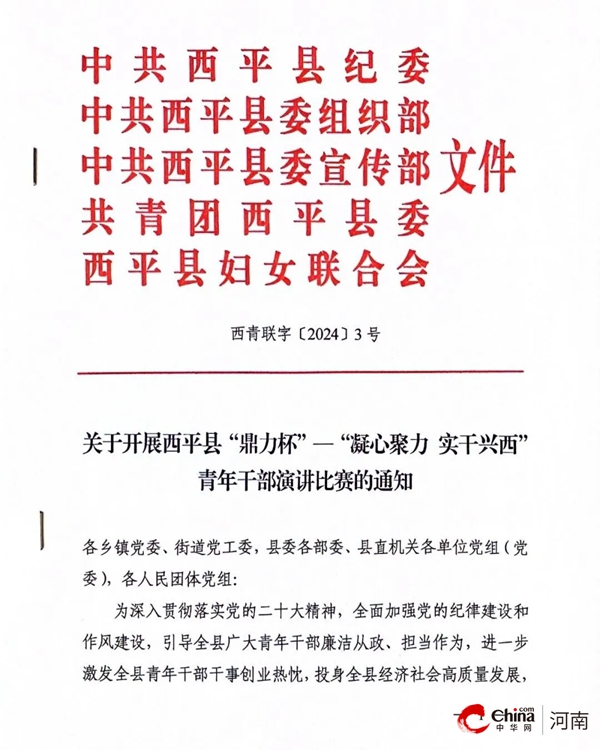

万卫星认为,与云端相比,端侧AI优势非常明显。除了成本优势,在隐私保护、更加个性化的用户体验以及随时享受AI等方面也独具优势。生成式AI在端侧部署给工作生活带来巨大变革,这是为什么只有让生成式AI部署在端侧,才能帮助生成式AI用例规模化扩展的重要原因所在。

【资料图】

【资料图】

AI向边缘下沉,对终端侧芯片、软件提出非常大的挑战。看似简单的AI图像识别、语音唤醒、“计算摄影”等等这些用例,其实对芯片的算力、DDR带宽都有非常强的需求,很难设计一种硬件IP(处理器),能够满足所有的这些应用。

“从我们的角度来讲,对于突发性的实时任务,我们会使用通用硬件加速单元,包括CPU和GPU,来对这种用例做加速;而对于持续型且需要高算力的应用,比如拍照、录像和生成式AI,我们会建议运行在我们的高算力、低功耗的NPU处理器上。如果大家对骁龙平台有所了解,我们还有一个超低功耗的传感器中枢,它特别适用于一些需要始终在线(always-on)的用例场景。”万卫星总结说,高通会利用在芯片上的优势,利用处理器的技术专长,设计出一个完整的异构计算系统,这个异构计算系统会把所有的处理器都囊括进去,针对不同的用例,采用不同的处理器组件做加速,从而提升用户体验。高通在设计的一开始就将AI的理念贯穿到整颗SoC。

在2023年骁龙峰会上,高通展示了一个利用异构计算做加速的用例,这是一个非常典型的能够充分挖掘高通骁龙平台上异构计算算力的场景。

“我们当时展示的用例,是一个与虚拟人进行采访或者对话的场景,其中就涉及了很多技术。首先,我们需要有一个语音处理模块,把语音信号转换成文本信号,这可以在CPU或者超低功耗的传感器中枢(Sensor Hub)上运行。接下来,我们需要利用大模型,生成对话输出文本,这可以在NPU上运行。然后,如果要完成语音对话的流程,我们还需要一个模块来把文字重新转换成语音,这可以用CPU或者GPU来做加速。最后,为了使双方互相看见对方,我们需要一个渲染引擎,将双方的形象在同一个场景里渲染出来,这个可以利用GPU进行加速。”万卫星介绍说。

近期,高通发布了《通过NPU和异构计算开启终端侧生成式AI》白皮书。在这份白皮书中,高通介绍了他们如何利用NPU和异构计算,实现丰富的终端侧生成式AI用例。总的来看,利用多种处理器进行异构计算,特别是NPU的表现,对于实现生成式AI应用最佳性能和能效至关重要。

万卫星认为,为了适配AI用例的多样性和终端的多样性,需要有这样一个异构计算系统,把各种处理器硬件加速单元,包括通用的CPU、GPU处理器,专用的NPU处理器,以及超低功耗的传感器中枢,都集成到白皮书提到的这个异构计算系统框架里。

生成式AI对NPU以及整个终端侧硬件芯片及软件带来非常大的挑战,高通具体是如何通过芯片设计、软件等满足这些用例的多样性的?

万卫星举例说,高通拥有一系列技术来应对大模型对DDR带宽的挑战,比如各种各样的量化技术、压缩技术,这些技术最主要的目的就是减少模型大小;针对大模型对算力的要求高,高通在NPU上做了非常专业的设计,比如专门针对底层的Transformer模块进行了加速,提出微切片技术专门针对DDR利用率做了优化,在架构上对硬件进行了升级。

除了硬件之外,高通在软件方面也做了大量工作。“我们之前推出了高通AI Stack,即高通AI软件栈产品,会在软件层面上兼容、支持目前高通异构计算系统里面所有的处理器组件。也就是说,用户可以非常方便地根据他们用例的具体需求,利用AI Stack接口来调用底层不同的处理器进行加速。高通AI Stack在一个模型从研究到优化到最后真正完成端侧部署这个完整链条上的各个节点,都提供了对应的工具,方便开发者和合作伙伴能够通过AI Stack做模型的开发、优化、部署工作等等。”万卫星介绍说。

在万卫星看来,相较于云端,端侧模型更倾向于专注于特定领域的小模型,旨在解决一些具体的问题,不需要特别强大的泛化能力或者通用能力。“未来,越来越多的用例和模型将向端侧迁移,从模型大小的角度来讲,迁往端侧的模型也将越来越大。”据万卫星介绍,高通去年成功支持了百亿参数(10B)的模型, 采用了INT4量化技术,从内存占用角度10B参数可以简单理解为相当于大概5G内存,未来,我们大概率能看到更大、更强的模型迁移到端侧。

谈到未来的产品形态,万卫星认为,未来的端侧产品应支持多模态,以便让用户体验能够更贴近真实的物理世界。此外,未来的产品可能不是简单地用来处理一些专注于特定领域的场景任务,而应具备AGI功能,“只有成为AGI,才能够真正地让我们的生活、工作、娱乐发生革命性变化,而不仅仅是一个简单的助手。我愿意将其称为类似于‘分身’的产品。”

标签: